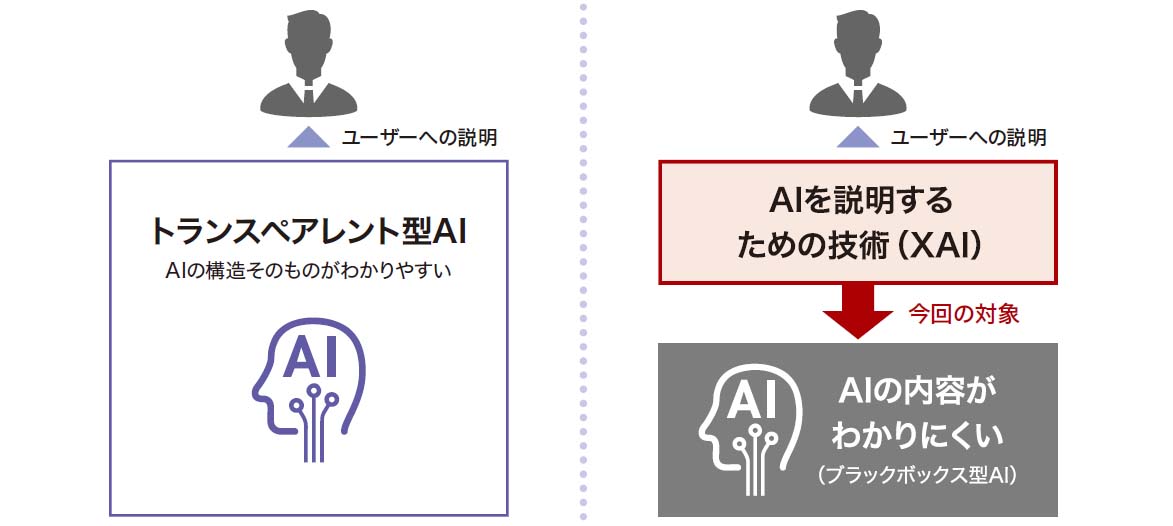

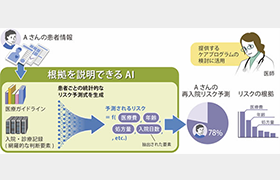

人工知能(AI)の判断根拠を多角的に分析して分り易く説明したり、複数のAIの結果や判断根拠から、評価結果を統合的に分り易く説明して、AIの説明性、透明性、品質、公平性などの要件を明らかにする技術です。深層学習に代表される技術の進展によりAIの精度は著しく向上し、さまざまな業務分野でのAI活用が広がり、人命、安全、財産に係わる重要な意思決定への活用にも期待が高まっています。これに合わせAIには精度だけでなく説明性、透明性、品質、公平性などの「信頼できるAI」としての要件が求められています。中でもAIが複雑なブラックボックスであるため、AIの判断根拠が分からず、AIの判断を安心して業務に活用できないという説明性への課題が顕著です。そこで日立は海外著名大学とも連携しながら、AIの判断根拠を多角的に分析し、人に分り易く説明するXAI(XAI: eXplainable AI)技術を開発し、さまざまな業務に適用してその有用性を検証してきました。さらにXAIを応用することで、その他のAI要件も効率的に解決できる見通しも得て来ました。今後はXAIをコアとした「信頼できるAI」の確立に向けた研究開発をすすめます。