ビッグデータでビジネスを成功に導くには:

トランザクションや顧客などの構造化データが爆発的に増えたことで、従来のETLシステムはスローダウンし、分析が適切なタイミングで実施できないという問題が発生するケースがあります。このような問題の解決手段として、Hadoopを活用したシナリオを紹介します。

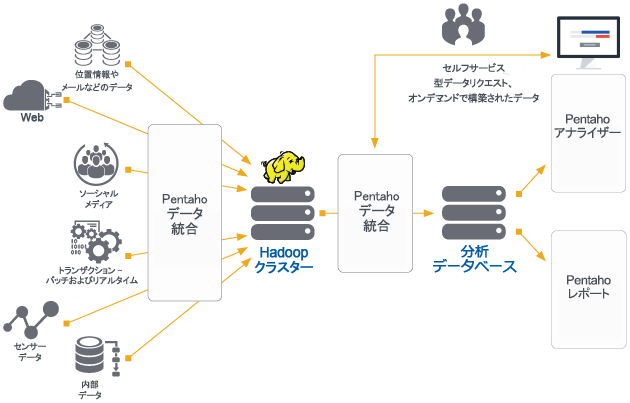

効率的なデータ精製により、オンデマンドであらゆるデータソースをブレンド、充実化、精製して、安全かつ分析に使用可能なデータセットにします。ビッグデータ処理のハブとしてHadoopを使用し、Pentahoのデータ統合機能(Pentaho Data Integration:PDI)により特定のデータセットの処理および精製を行います。1回のクリックで、データセットが自動的にモデル化、公開され、ユーザーはそのデータへすぐにアクセスし、分析できます。

Pentahoのデータ統合・分析基盤と組み合わせることにより、Hadoopはパフォーマンスの高い、マルチソースのビジネス情報のハブとなるため、データを流してブレンドした後に、精製されたデータセットを代表的な分析データベース(Amazon RedshiftやHP Verticaなど)に自動的に公開できます。エンドユーザー向けには、データディスカバリーを始め、レポート、ダッシュボード、および可視化といった豊富な分析機能が用意されており、これらを使っていつでも高度な分析を行うことができます。