2021年5月28日

株式会社日立製作所

株式会社日立製作所と早稲田大学理工学術院の尾形 哲也(おがた てつや)教授の研究グループは、これまでロボットの作業能力の限界によって導入が進んでいなかった作業現場の自動化をめざし、複雑な動作を容易に実現することができる深層学習型のロボット制御技術を開発しました。本技術は、ロボットの手先や対象物の特徴情報を学習により自動抽出することで、形状が変わる物体のハンドリング(例えば、ケーブルやカバーの設置、液体および粉体を取扱う作業など)をプログラミングレスで習得できます。さらに、対象物の物理的特徴(色や形状など)と動作内容(掴むや押すなど)を含んだ言語指示から、学習していない動作を連想して実行することが可能です。今後、ロボットが導入されていない、さまざまな現場作業を自動化することで、人の作業を支援するシステムを構築し、少子高齢化に伴う労働力不足の解決をめざします。

ロボット動作の学習に、国立研究開発法人産業技術総合研究所のAI橋渡しクラウド(ABCI)を活用しました。

本研究成果の一部は、5月31日~6月6日に開催されるThe 2021 International Conference on Robotics and Automation (ICRA 2021) のWorkshop*1 と、6月6日~8日に開催される日本機械学会 ロボティクス・メカトロニクス講演会2021 (ROBOMECH2021) のポスターセッションにて発表予定です。

今回開発した深層学習型ロボット制御技術は、以下の技術により構成されています。

従来のロボット制御技術では、物体認識で得られた情報をもとに、対象物の向きや形状に対する想定可能なすべての動作を人手でプログラム(軌道計画)していました。そのため、布や紐など接触により形状が変化する不定形物を操作する動作では、すべての状況をプログラムで記述するのは難しいという課題がありました。これに対し本技術は、人がロボットに所望の動作を複数回教示するだけで、ロボットの視覚・触覚情報から着目すべき情報(対象物の位置や方向など)と、その時に取るべき動作を自動抽出し*2 、不定形物作業中の新たな状況に対する動作も、プログラミングレスで実行することが可能になりました。

図1 軌道計画に必要な情報を自動抽出する動作生成技術の仕組み

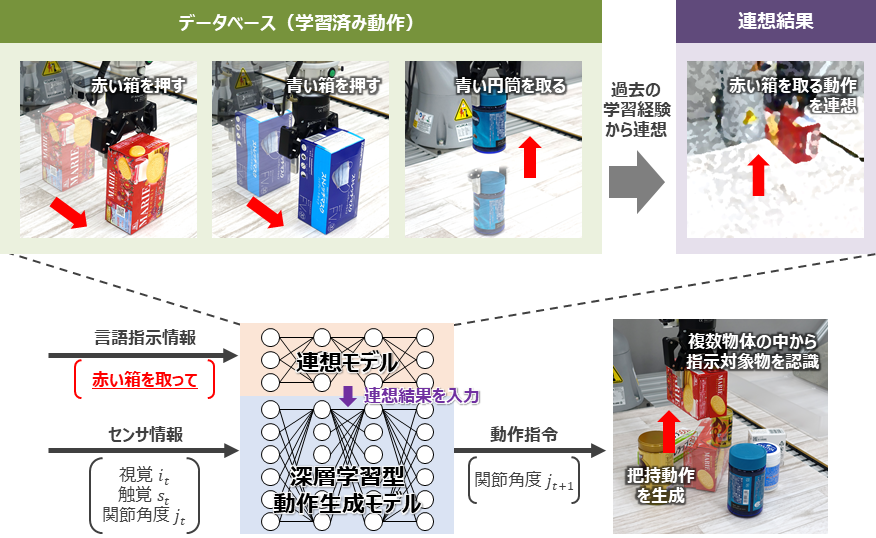

人の言語指示(音声やテキスト文などの人が理解できる情報)に基づいて所望の動作を実現するためには、言語指示と動作の関係をすべて人手でプログラムしていました。そのため、動作や対象物を追加する度に言語指示との対応付けを行う必要がありました。本技術は、ロボットの動作と対象物、そして言語指示の関係を学習し、データベースに記憶します。対象物の物理的特徴(色や形状など)と動作内容(掴むや押すなど)を含んだ言語指示から、データベースに記憶した類似動作の連想結果を動作生成モデルに入力することで、未学習の言語指示から所望の動作を自律的に実行する技術を開発しました*3 。これにより、言語指示と動作の関係をすべてプログラムする必要がなくなり、対応可能な動作バリエーションの増大を実現しました。

図2 指示対象物と動作を連想する連想技術の仕組み